We współczesnym świecie ludzie są zalewani olbrzymią ilością informacji. Coraz większa ilość informacji i dokumentów stwarza problemy z ich przetwarzaniem. Czas dotarcia do informacji wydłuża się. Z tego względu coraz ważniejsze staje się ich porządkowanie. Większość informacji przetwarzanych w organizacjach można pogrupować w procesy biznesowe. Zarządzanie procesami biznesowymi jest bardzo ważnym wyzwaniem, gdyż wydajność obsługi procesami biznesowymi wpływa na wydajność całej organizacji.Ciekawe wnioski płyną z badań przeprowadzonych przez firmę Konica Minolta:

Pracownik biurowy poświęca blisko 20% swojego czasu na poszukiwanie dokumentów.

U ponad 60% średnich firm wciąż dominującą formą dokumentu jest forma papierowa.

W średnich firmach dwie na trzy firmy korzystają z systemu obiegu dokumentów, ale mniej niż 10% w pełni wykorzystuje ich funkcjonalność.

Dlaczego warto wdrożyć obieg dokumentów?

Standaryzacja procesów

Standaryzacja procesów pozwala mieć pewność, że podobne sprawy są załatwiane w podobny sposób w całej organizacji i nie zależy to od kompetencji i wiedzy konkretnych pracowników. Dzięki temu obsługa procesów może być optymalizowana na poziomie całej organizacji, a nie tylko lokalnie, poprzez rozszerzanie wiedzy pojedynczych ludzi.

Zwiększenie efektywności

Wdrożenie obiegu dokumentów pozwala nam w jasny sposób określić role użytkowników w każdym z procesów. Dzięki temu każdy użytkownik dostaje tylko te informacje, które są mu potrzebne i dostaje je w odpowiednim momencie. Ogranicza się dzięki temu angażowanie użytkowników niepotrzebnie i dzięki temu udaje się zwiększyć efektywność pracy. Jednocześnie informacje i dokumenty znajdują się w łatwo przewidywalnym miejscu, dzięki czemu dostęp do nich jest łatwiejszy.

Bezpieczeństwo informacji

System obiegu dokumentów zwykle zapewnia również nadawanie uprawnień do informacji dla konkretnych użytkowników i grup, w zależności od ich roli i etapu procesu. Pozwala to na precyzyjne kontrolowanie dostępu informacji. Ma to kolosalne znaczenie w sytuacji przetwarzania danych poufnych lub będących tajemnicą przedsiębiorstwa. Dzięki systemowi uprawnień możemy dawać dostęp do informacji uczestnikom procesu tylko w zakresie w jakim jest on niezbędny.

Drugim elementem bezpieczeństwa informacji jest zabezpieczenie przed utratą informacji lub jej niekontrolowaną modyfikacją. Służą temu mechanizmy zapisu historii zmian dokumentów i wersjonowania dokumentów. Dzięki temu możemy dokładnie sprawdzić kto i kiedy zmodyfikował informację przechowywaną w systemie, a także powrócić do jej wcześniejszej wersji. Dotyczy to również odtwarzania dokumentów, które zostały przez użytkownika świadomie lub przypadkowo usunięte.

Zarządzanie wiedzą

Kolejnym kluczowym argumentem za wdrożeniem systemu obiegu dokumentów jest przechowywanie wiedzy wewnątrz organizacji i jej utrzymywanie w systemie, a nie tylko w głowach użytkowników. Jeśli tego nie zrobimy to każda rotacja zasobów ludzkich, np. odejście pracownika z pracy powoduje utratę wiedzy z organizacji. A wiedza jest elementem wartości firmy i coraz cenniejszym dobrem.

Modelowanie obiegu dokumentów

Klasyczny sposób modelowania obiegu dokumentów

Większość obecnie spotykanych na rynku systemów obiegu dokumentów charakteryzuje się wspólnym podejściem do procesu analizy procesów. I mimo tego, że dostępne systemy mogą się mocno różnić zakresem możliwości, funkcjonalnością i ceną to większość z nich stosuje ten sam model działania. Polega on na tym, że przed wdrożeniem systemu obiegu dokumentów musi nastąpić dosyć dokładna analiza procesów, które mają być zamodelowane. Czyli najpierw analiza procesów przeprowadzana jest przez analityka, który próbuje uzyskać wiedzę o procesach od docelowych użytkowników oraz od osób decyzyjnych. Następnie analiza ta jest uzgadniana z klientem i przekazywana konsultantom technicznym w celu wdrożenia. Ich zadaniem jest takie skonfigurowanie i przygotowanie systemu, aby użytkownicy końcowi obsługiwali procesy według uzgodnionej analizy.

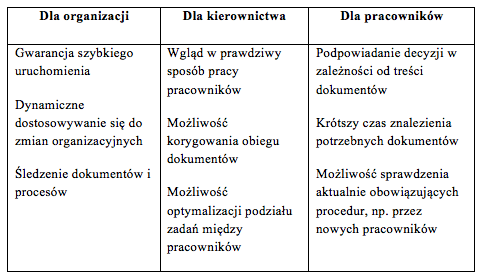

Podsumowanie korzyści:

Zapraszamy do przeczytania artykułu w całości >

...............................................................................................................................................................

Sanmargar Team jest ekspertem w obszarze rozwiązań business intelligence (BI), w tym hurtowni danych, systemów obiegu informacji, kontroli jakości danych oraz rozwiązań analityczno-raportowych.

Przegląd informacji na temat innowacyjnych projektów i nowych zjawisk dotyczących obszaru "business intelligence" oraz zarządzania hurtowniami danych.

poniedziałek, 21 października 2013

niedziela, 13 października 2013

Gartner: 64% firm zamierza inwestować w Big Data

Niemal 2/3 firm biorących udział w ankiecie przeprowadzonej przez firmę badawczą Gartner, zapytanych o plany inwestycyjne w zakresie Big Data, przyznało, że inwestuje lub zamierza zainwestować w tego typu projekty jeszcze w tym roku. Liderem badania, obejmującego 720 organizacji, okazały się firmy z sektora bankowego oraz mediów i komunikacji.

Osoby zainteresowane tematem Big Data zapraszamy w imieniu organizatorów na konferencję "Big Data Experience - Analizuj. Estymuj. Zarabiaj".

Już ponad 1/3 firm działających na rynku mediów i komunikacji zainwestowała w przedsięwzięcia typu Big Data. Zdaniem firmy badawczej Gartner, celem tych inwestycji jest lepsze zrozumienie potrzeb klienta i uzyskanie pewności, że prowadzone przez firmę działania biznesowe zmierzają we właściwym kierunku.

"Rok 2013 jest to rok eksperymentów i rozwoju w obszarze Big Data”, powiedział Frank Buytendijk, wiceprezydent ds. badań w Gartner. „Poziom przyswojenia tego typu rozwiązań przez firmy jest nadal w fazie początkowej – niecałe 8% wszystkich respondentów deklaruje, że zostały one wdrożone w ich firmie. Tymczasem, 20% badanych prowadzi eksperymenty i projekty pilotażowe, 18% jest na etapie opracowywania strategii, a 19% dopiero gromadzi potrzebną wiedzę. Pozostali badania nie planują inwestycji w Big Data albo nic o takich planach nie wiedzą."

Podobnego zagadnienia dotyczyło sympozjum Council for Research Excellence (CRE) odbywające się niedawno w nowojorskim Time & Life Building. Spotkanie pozwoliło uchwycić przyczyny, dla których najprawdopodobniej koncerny medialne wykazują aż tak duże zainteresowanie gromadzeniem dużych zbiorów danych pochodzących z wielu źródeł, co ma im pomóc w lepszym zrozumieniu odbiorców.

Temat zorganizowanego przez CRE panelu dyskusyjnego, w którym uczestniczyli menedżerowie i analitycy z branży nadawczej, dotyczył wiarygodnych sposobów matematycznego “modelowania” zależności występujących między oglądalnością, reklamą i działaniami promocyjnymi. Zagadnienia związane z modelowaniem, od którego wyników zależą miliony dolarów przeznaczonych na reklamę, nęka branżę od pierwszych dni narodzin radia i telewizji. Teraz, gdy wpływ na opinię publiczną wywierają też media społecznościowe, a rynek nadawców online nabiera tempa, kwestia “modelowania” siły oddziaływania reklamy i oglądalności staje się coraz bardziej złożona.

Podczas panelu CRE hasło „Big Data” pojawiało się nagminnie. Zdaniem Dave’a Poltracka, dyrektora ds. badań CBS, branża nadawcza znajduje się właśnie w punkcie zwrotnym , co spowodowane jest pojawieniem się nowych mediów i pogłębioną przez to potrzebą stworzenia innych modeli analitycznych.

Stacja CBS, żywo zainteresowana zagadnieniami Big Data, powiększa swój dział badawczy o nowe osoby – młodych pracowników znających środowisko online i media społecznościowe, jednocześnie posiadających bogatą wiedzę analityczną – co ma zwiększyć perspektywy CBS. „Prowadzone są rozmowy na temat inwestycji w Big Data, a niektóre projekty są realizowane już teraz”, powiedział Poltrack. Jego zdaniem, badacze szukają sposobu na połączenie tradycyjnej wiedzy na temat oglądalności z nową wiedzą na temat aktywności online, w takich mediach społecznościowych jak Facebook i Twitter. Ma to wesprzeć program oferowany przez stację CBS i jej ogólną działalność biznesową.

Jim Spaeth, partner w firmie doradczej Sequent Partners, uczestnik panelu CRE, zwrócił uwagę na fakt, że media społecznościowe stały się w reklamie nowym „symbolem złożoności”. Jego zdaniem, modele analityczne dotyczące serwisów społecznościowych są dużo bardziej skomplikowane niż dotychczas, a media społecznościowe „szerzą się w zastraszającym tempie”. Firmy chcą jednak wiedzieć, jak wielokanałowe kampanie reklamowe w mediach cyfrowych i tradycyjnych wpływają również na poziom oglądalności oraz zwyczaje zakupowe konsumentów. Jako część strategii działań w obszarze Big Data rozważa się również reklamę mobilną, choć tworzenie modeli dla tego typu reklamy nie odbywa się w tak szerokim zakresie.

Niemniej jednak, słychać również głosy sceptycyzmu. Dotyczą one, przede wszystkim, wartości, jakie dają rozwiązania Big Data w kontekście diagnozowania siły oddziaływania reklamy i jej wpływu na poziom oglądalności na pograniczu nowych i tradycyjnych mediów, biorąc pod uwagę fakt niewspółmierności danych łączonych w duże zbiory w celach analitycznych. Mike Donahue, wiceprezes Amerykańskiego Stowarzyszenia Agencji Reklamowych, w swoim wystąpieniu podczas panelu CRE stwierdził, że dążeniem i celem Big Data jest, co prawda, szerszy kontekst, jednak branża nie powinna stracić z oczu "mniejszych strumieni danych" odnoszących się do konkretnych, lokalnych rynków.

Osoby zainteresowane tematem Big Data zapraszamy na konferencję "Big Data Experience - Analizuj. Estymuj. Zarabiaj".

Osoby zainteresowane tematem Big Data zapraszamy w imieniu organizatorów na konferencję "Big Data Experience - Analizuj. Estymuj. Zarabiaj".

Już ponad 1/3 firm działających na rynku mediów i komunikacji zainwestowała w przedsięwzięcia typu Big Data. Zdaniem firmy badawczej Gartner, celem tych inwestycji jest lepsze zrozumienie potrzeb klienta i uzyskanie pewności, że prowadzone przez firmę działania biznesowe zmierzają we właściwym kierunku.

"Rok 2013 jest to rok eksperymentów i rozwoju w obszarze Big Data”, powiedział Frank Buytendijk, wiceprezydent ds. badań w Gartner. „Poziom przyswojenia tego typu rozwiązań przez firmy jest nadal w fazie początkowej – niecałe 8% wszystkich respondentów deklaruje, że zostały one wdrożone w ich firmie. Tymczasem, 20% badanych prowadzi eksperymenty i projekty pilotażowe, 18% jest na etapie opracowywania strategii, a 19% dopiero gromadzi potrzebną wiedzę. Pozostali badania nie planują inwestycji w Big Data albo nic o takich planach nie wiedzą."

Podobnego zagadnienia dotyczyło sympozjum Council for Research Excellence (CRE) odbywające się niedawno w nowojorskim Time & Life Building. Spotkanie pozwoliło uchwycić przyczyny, dla których najprawdopodobniej koncerny medialne wykazują aż tak duże zainteresowanie gromadzeniem dużych zbiorów danych pochodzących z wielu źródeł, co ma im pomóc w lepszym zrozumieniu odbiorców.

Temat zorganizowanego przez CRE panelu dyskusyjnego, w którym uczestniczyli menedżerowie i analitycy z branży nadawczej, dotyczył wiarygodnych sposobów matematycznego “modelowania” zależności występujących między oglądalnością, reklamą i działaniami promocyjnymi. Zagadnienia związane z modelowaniem, od którego wyników zależą miliony dolarów przeznaczonych na reklamę, nęka branżę od pierwszych dni narodzin radia i telewizji. Teraz, gdy wpływ na opinię publiczną wywierają też media społecznościowe, a rynek nadawców online nabiera tempa, kwestia “modelowania” siły oddziaływania reklamy i oglądalności staje się coraz bardziej złożona.

Podczas panelu CRE hasło „Big Data” pojawiało się nagminnie. Zdaniem Dave’a Poltracka, dyrektora ds. badań CBS, branża nadawcza znajduje się właśnie w punkcie zwrotnym , co spowodowane jest pojawieniem się nowych mediów i pogłębioną przez to potrzebą stworzenia innych modeli analitycznych.

Stacja CBS, żywo zainteresowana zagadnieniami Big Data, powiększa swój dział badawczy o nowe osoby – młodych pracowników znających środowisko online i media społecznościowe, jednocześnie posiadających bogatą wiedzę analityczną – co ma zwiększyć perspektywy CBS. „Prowadzone są rozmowy na temat inwestycji w Big Data, a niektóre projekty są realizowane już teraz”, powiedział Poltrack. Jego zdaniem, badacze szukają sposobu na połączenie tradycyjnej wiedzy na temat oglądalności z nową wiedzą na temat aktywności online, w takich mediach społecznościowych jak Facebook i Twitter. Ma to wesprzeć program oferowany przez stację CBS i jej ogólną działalność biznesową.

Jim Spaeth, partner w firmie doradczej Sequent Partners, uczestnik panelu CRE, zwrócił uwagę na fakt, że media społecznościowe stały się w reklamie nowym „symbolem złożoności”. Jego zdaniem, modele analityczne dotyczące serwisów społecznościowych są dużo bardziej skomplikowane niż dotychczas, a media społecznościowe „szerzą się w zastraszającym tempie”. Firmy chcą jednak wiedzieć, jak wielokanałowe kampanie reklamowe w mediach cyfrowych i tradycyjnych wpływają również na poziom oglądalności oraz zwyczaje zakupowe konsumentów. Jako część strategii działań w obszarze Big Data rozważa się również reklamę mobilną, choć tworzenie modeli dla tego typu reklamy nie odbywa się w tak szerokim zakresie.

Niemniej jednak, słychać również głosy sceptycyzmu. Dotyczą one, przede wszystkim, wartości, jakie dają rozwiązania Big Data w kontekście diagnozowania siły oddziaływania reklamy i jej wpływu na poziom oglądalności na pograniczu nowych i tradycyjnych mediów, biorąc pod uwagę fakt niewspółmierności danych łączonych w duże zbiory w celach analitycznych. Mike Donahue, wiceprezes Amerykańskiego Stowarzyszenia Agencji Reklamowych, w swoim wystąpieniu podczas panelu CRE stwierdził, że dążeniem i celem Big Data jest, co prawda, szerszy kontekst, jednak branża nie powinna stracić z oczu "mniejszych strumieni danych" odnoszących się do konkretnych, lokalnych rynków.

Osoby zainteresowane tematem Big Data zapraszamy na konferencję "Big Data Experience - Analizuj. Estymuj. Zarabiaj".

Big Data - rewolucja w marketingu

Big Data to termin odmieniany przez wszystkie przypadki. Nic dziwnego, bowiem coraz głośniej mówi się, że przyszłość należy do tych, którzy mają kompetencje do zaawansowanej obróbki danych. O tym czy jest Big Data i jak wpływa na marketing można było dowiedzieć się na konferencji zorganizowanej przez MrAcademy, zatytułowanej "Big Data Revolution – w marketingu" która odbyła się 8 października w Warszawie.

Konferencję otworzyła prelekcja Sebastiana Starzyńskiego, od którego uczestnicy mogli usłyszeć, że "Big Data to nowy temat, a takowe w naszym kraju szybko się nie popularyzują. Na wykorzystaniu Big Data skorzystają nieliczni. Przede wszystkim firmy zagraniczne, które zatrudnią utalentowanych polskich analityków z dużym potencjałem w zakresie obróbki danych. Podmioty gromadzące duże zbiory danych zaczną dostrzegać ich potencjał. Wtedy dane przestaną być kosztem, a staną się kapitałem. O stopie zwrotu zadecyduje nie intuicja marketera, ale inwencja analityka Big Data. Marketer natomiast w pracy częściej wykorzysta interpretację danych niż intuicję."

Intresującą konstatacją podzielił się z uczestnikami Rafał Roszak, Dyrektor Marketingu w e24cloud: "Marketing to już nie jest kwestia kreacji, ale przede wszystkich analizy danych", po czym dodał: "wszysycy mówią o BIG DATA, ale by uzyskać naprawdę wartościowe informację, trzeba umieć zadać odpowiednie pytanie."

Gwoździem programu było wystąpienie Gabe’a Gottharda, inwestora i praktyka biznesu z 30letnim doświadczeniem w rozwoju i marketingu produktów high-tech. Gotthard jest cenionym Aniołem Biznesu, znanym w Stanach Zjednoczonych i Europie Zachodniej. Inwestor wspomaga projekty z branży informatycznej, między innymi polską spółkę hightech PILAB, specjalizującą się w produkcji oprogramowania na bazie autorskiego know-how z zakresu zarządzania bazami danych oraz wszelkiego rodzaju zasobami cyfrowymi. W swoim wystąpieniu Gabe mocno podkreślił duży potencjał branży IT z Polski i Europy Środkowo – Wschodniej, który ma szansę zawalczyć o globalny rynek. Zwieńczeniem wystąpienia Gottharda był panel dyskusyjny z udziałem inwestora z Doliny Krzemowej, Ryszarda Kubisa Prezesa jednej ze spółek w ramach grupy PCC oraz Pawła Wieczyńskiego, Członka Zarządu PILAB.

Puentą wystąpienia Grzegorza Błażewicza, CEO & Founder, SALESmanago Marketing Automation było stwierdzenie, że "zastosowanie systemu Marketing Automation w firmie pozwala gromadzić bardzo ważne dane o aktualnych i potencjalnych klientach oraz budować automatyczne, personalizowane procesy marketingowo-sprzedażowe, które budują wartość firmy. To znacznie poprawia sytuację marketera, którego dotychczasowa praca często obrazowana jest dziełem Pierra Manzoniego pt. Merde d'artista."

Z kolei Maciej Kutak, Vice President, Replise podczas prelekcji, opowiedział o korzyściach wynikających z wykorzystania analizy User Generated Content, czyli treści publikowanych w Internecie. Przedstawione case study ukazały walory posiadania wiedzy zdobytej dzięki badaniom danych zamieszczanych przez internautów w mediach społecznościowych, na podstawie których, z punktu widzenia biznesu, marketer może uzyskać dokładną wiedzę na temat profili społeczno-demograficzych oraz behawioralnych swoich konsumentów.

Grzegorz Kosiński, Dyrektor Zarządzający, Data Exchanger, podkreślając rolę Big Data w marketingu, stwierdził, że "dzięki wykorzystaniu dobrych jakościowo danych behawioralnych możemy docierać do potencjalnych klientów nawet kilkakrotnie taniej w porównaniu do konwencjonalnych działań e-marketingowych".

Z dużym zainteresowaniem spotkała się prezentacja Rafała Staszkiewicza, Partnera i Country Managera, Adello Polska, który pokazał zastosowanie Big Data w nowej generacji reklamy mobilnej, a także wystąpienie Mariusza Pawełczyka, Sales Directora CEE, Sociomantic Labs, który dane określił mianem paliwa dla e-commerce i sprawnego online marketingu.

Podczas konferencji Big Data - rewolucja w marketingu nie zabrakło również prelekcji poświęconej jednemu z najbardziej przyszłościowych zawodów, jakim jest analityk danych. Krzysztof Sobieszek, Pełnomocnik Zarządu ds. Marketingu i Danych w spółce Nasza Klasa, który podjął ten temat tak zakończył swoje wystąpienie: "Bez dwóch zdań na znaczeniu zyskuje tez zupełnie nowy zawód czyli 'data scientist'. Są to osoby łączące bardzo wysokie kompetencje informatyczne z najnowszymi metodami analizy wielkich zbiorów danych. Tych osób jest bardzo mało na świecie, a tym bardziej w Polsce." Zdaniem Sobieszka ich pozyskiwanie i kształcenie będzie jedną z ważniejszych przewag w wykorzystywaniu potencjału Big Data.

Źródło: Media

PREZENTACJE Z KONFERENCJI DOSTĘPNE SĄ NA STRONIE:

http://mediarun.com/academy/big-data/

Konferencję otworzyła prelekcja Sebastiana Starzyńskiego, od którego uczestnicy mogli usłyszeć, że "Big Data to nowy temat, a takowe w naszym kraju szybko się nie popularyzują. Na wykorzystaniu Big Data skorzystają nieliczni. Przede wszystkim firmy zagraniczne, które zatrudnią utalentowanych polskich analityków z dużym potencjałem w zakresie obróbki danych. Podmioty gromadzące duże zbiory danych zaczną dostrzegać ich potencjał. Wtedy dane przestaną być kosztem, a staną się kapitałem. O stopie zwrotu zadecyduje nie intuicja marketera, ale inwencja analityka Big Data. Marketer natomiast w pracy częściej wykorzysta interpretację danych niż intuicję."

Intresującą konstatacją podzielił się z uczestnikami Rafał Roszak, Dyrektor Marketingu w e24cloud: "Marketing to już nie jest kwestia kreacji, ale przede wszystkich analizy danych", po czym dodał: "wszysycy mówią o BIG DATA, ale by uzyskać naprawdę wartościowe informację, trzeba umieć zadać odpowiednie pytanie."

Gwoździem programu było wystąpienie Gabe’a Gottharda, inwestora i praktyka biznesu z 30letnim doświadczeniem w rozwoju i marketingu produktów high-tech. Gotthard jest cenionym Aniołem Biznesu, znanym w Stanach Zjednoczonych i Europie Zachodniej. Inwestor wspomaga projekty z branży informatycznej, między innymi polską spółkę hightech PILAB, specjalizującą się w produkcji oprogramowania na bazie autorskiego know-how z zakresu zarządzania bazami danych oraz wszelkiego rodzaju zasobami cyfrowymi. W swoim wystąpieniu Gabe mocno podkreślił duży potencjał branży IT z Polski i Europy Środkowo – Wschodniej, który ma szansę zawalczyć o globalny rynek. Zwieńczeniem wystąpienia Gottharda był panel dyskusyjny z udziałem inwestora z Doliny Krzemowej, Ryszarda Kubisa Prezesa jednej ze spółek w ramach grupy PCC oraz Pawła Wieczyńskiego, Członka Zarządu PILAB.

Puentą wystąpienia Grzegorza Błażewicza, CEO & Founder, SALESmanago Marketing Automation było stwierdzenie, że "zastosowanie systemu Marketing Automation w firmie pozwala gromadzić bardzo ważne dane o aktualnych i potencjalnych klientach oraz budować automatyczne, personalizowane procesy marketingowo-sprzedażowe, które budują wartość firmy. To znacznie poprawia sytuację marketera, którego dotychczasowa praca często obrazowana jest dziełem Pierra Manzoniego pt. Merde d'artista."

Z kolei Maciej Kutak, Vice President, Replise podczas prelekcji, opowiedział o korzyściach wynikających z wykorzystania analizy User Generated Content, czyli treści publikowanych w Internecie. Przedstawione case study ukazały walory posiadania wiedzy zdobytej dzięki badaniom danych zamieszczanych przez internautów w mediach społecznościowych, na podstawie których, z punktu widzenia biznesu, marketer może uzyskać dokładną wiedzę na temat profili społeczno-demograficzych oraz behawioralnych swoich konsumentów.

Grzegorz Kosiński, Dyrektor Zarządzający, Data Exchanger, podkreślając rolę Big Data w marketingu, stwierdził, że "dzięki wykorzystaniu dobrych jakościowo danych behawioralnych możemy docierać do potencjalnych klientów nawet kilkakrotnie taniej w porównaniu do konwencjonalnych działań e-marketingowych".

Z dużym zainteresowaniem spotkała się prezentacja Rafała Staszkiewicza, Partnera i Country Managera, Adello Polska, który pokazał zastosowanie Big Data w nowej generacji reklamy mobilnej, a także wystąpienie Mariusza Pawełczyka, Sales Directora CEE, Sociomantic Labs, który dane określił mianem paliwa dla e-commerce i sprawnego online marketingu.

Podczas konferencji Big Data - rewolucja w marketingu nie zabrakło również prelekcji poświęconej jednemu z najbardziej przyszłościowych zawodów, jakim jest analityk danych. Krzysztof Sobieszek, Pełnomocnik Zarządu ds. Marketingu i Danych w spółce Nasza Klasa, który podjął ten temat tak zakończył swoje wystąpienie: "Bez dwóch zdań na znaczeniu zyskuje tez zupełnie nowy zawód czyli 'data scientist'. Są to osoby łączące bardzo wysokie kompetencje informatyczne z najnowszymi metodami analizy wielkich zbiorów danych. Tych osób jest bardzo mało na świecie, a tym bardziej w Polsce." Zdaniem Sobieszka ich pozyskiwanie i kształcenie będzie jedną z ważniejszych przewag w wykorzystywaniu potencjału Big Data.

Źródło: Media

PREZENTACJE Z KONFERENCJI DOSTĘPNE SĄ NA STRONIE:

http://mediarun.com/academy/big-data/

poniedziałek, 7 października 2013

Team F1 Caterham inwestuje w ... analitykę Big Data

Każdy team F1 posiada rozbudowane zaplecze inżynierskie. Wiele firm współpracuje dodatkowo z zewnętrznymi kooperantami, którzy pozwalają na zintensyfikowanie rozwoju auta i wnoszą świeże spojrzenie na projekt. Caterham współdziała z firmą GE i cały czas poszerza obszar tej działalności.

Naukowcy z GE Global Research (GRC) pracując na co dzień w USA, Niemczech czy Indiach tworzą rozwiązania w obszarze analityki Big Data i badań materiałowych, które pozwalają zwiększyć osiągi bolidów Caterham F1 Team. Ta współpraca to obopólna korzyść - mówi Matt Nielsen, szef działu układów sterujących, elektroniki i przetwarzania sygnałów w GRC - Ich cykl rozwoju technologii jest niewiarygodnie krótki, często to tylko dwa tygodnie między wyścigami. Uczymy się więc wdrażania technologii w krótkim oknie czasowym.

Prace zespołu GE skupiają się na czterech obszarach, które mają poprawić czasy okrążeń bolidu. Są to: analityka Big Data, czujniki światłowodowe, wytwarzanie kompozytów i gospodarka cieplna. Każdy bolid Caterhama jest wyposażony w około 500 czujników rozsianych po całej konstrukcji, znajdują sie one między innymi w kołach, silniku, skrzyni biegów czy nadwoziu. Razem wzięte generują do 1000 danych na sekundę. Gigabajty danych przesyłane są do centrali Caterhama w Anglii, gdzie zespół inżynierów porównuje je z informacjami uzyskanymi w trakcie rozwoju technologii, testów w tunelu powietrznym, czy prób w symulatorze.

Ogrom danych kompletnie nas zaskoczył - mówi Nielsen - Pomagamy im spojrzeć na to, jak zarządzają swoimi danymi, a następnie wyłuskać cenne szczegóły, które mogą przyczynić się do wyciśnięcia z konstrukcji kolejnych tysięcznych sekundy...

Więcej >

...................................................................................................................................................................

Sanmargar Team jest jest jednym z czołowych dostawców rozwiązań business intelligence na rynku polskim. Sanmargar Team dostarcza rozwiązania analityczne i raportowe, w tym Pentaho Business Analytics - wydajną platformę raportową i integracyjną.

Naukowcy z GE Global Research (GRC) pracując na co dzień w USA, Niemczech czy Indiach tworzą rozwiązania w obszarze analityki Big Data i badań materiałowych, które pozwalają zwiększyć osiągi bolidów Caterham F1 Team. Ta współpraca to obopólna korzyść - mówi Matt Nielsen, szef działu układów sterujących, elektroniki i przetwarzania sygnałów w GRC - Ich cykl rozwoju technologii jest niewiarygodnie krótki, często to tylko dwa tygodnie między wyścigami. Uczymy się więc wdrażania technologii w krótkim oknie czasowym.

Prace zespołu GE skupiają się na czterech obszarach, które mają poprawić czasy okrążeń bolidu. Są to: analityka Big Data, czujniki światłowodowe, wytwarzanie kompozytów i gospodarka cieplna. Każdy bolid Caterhama jest wyposażony w około 500 czujników rozsianych po całej konstrukcji, znajdują sie one między innymi w kołach, silniku, skrzyni biegów czy nadwoziu. Razem wzięte generują do 1000 danych na sekundę. Gigabajty danych przesyłane są do centrali Caterhama w Anglii, gdzie zespół inżynierów porównuje je z informacjami uzyskanymi w trakcie rozwoju technologii, testów w tunelu powietrznym, czy prób w symulatorze.

Ogrom danych kompletnie nas zaskoczył - mówi Nielsen - Pomagamy im spojrzeć na to, jak zarządzają swoimi danymi, a następnie wyłuskać cenne szczegóły, które mogą przyczynić się do wyciśnięcia z konstrukcji kolejnych tysięcznych sekundy...

Więcej >

...................................................................................................................................................................

Sanmargar Team jest jest jednym z czołowych dostawców rozwiązań business intelligence na rynku polskim. Sanmargar Team dostarcza rozwiązania analityczne i raportowe, w tym Pentaho Business Analytics - wydajną platformę raportową i integracyjną.

piątek, 4 października 2013

"Advanced Analytics and Data Science" Konferencja 5 listopada 2013

W imieniu organizatorów zaproszamy na konferencję "Advanced Analytics and Data Science"

Konferencja "Advanced Analytics and Data Science" to wyjątkowe wydarzenie dla przedstawicieli świata nauki i biznesu, którego celem jest zaprezentowanie wymiernych wartości wynikających z zastosowania zaawansowanych rozwiązań analitycznych w biznesie oraz zainicjowanie dyskusji na temat wyzwań związanych z uruchamianiem nowych programów studiów i kształceniem specjalistów posiadających odpowiednie kompetencje analityczne, informatyczne i biznesowe (data scientist) dostosowane do zmieniających potrzeb współczesnej gospodarki.

Konferencja organizowana jest przez Szkołę Główną Handlową w Warszawie (Kolegium Analiz Ekonomicznych - Instytut Statystyki i Demografii - Zakład Analizy Historii Zdarzeń i Analizy Wielopoziomowych) pod honorowym patronatem JM Rektora – prof. dr hab. Tomasza Szapiro.

Wiele polskich uczelni, w tym Szkoła Główna Handlowa w Warszawie, przechodzi przez proces zmian i adaptacji programów kształcenia do aktualnych realiów rynku. Organizacje chcą wykorzystać możliwości, jakie kryją się za analizą i wizualizacją zalewających ich danych i informacji. Dlatego rośnie znaczenie data science zarówno jako specjalizacji i zawodu, jak i dyscypliny naukowej. Big Data zmienia oblicze biznesu, dlatego firmy potrzebują zaawansowanych technologii i specjalistycznych kompetencji, aby przekształcić dostępne dane w wiedzę zapewniającą im przewagę konkurencyjną.

Gościem specjalnym konferencji będzie Frank J. Ohlhorst – dziennikarz, autor, prezenter i blogger, ekspert w dziedzinie analityki biznesowej z dużym doświadczeniem w realizacji projektów IT dla biznesu. Autor książki Big Data Analytics: Turning Big Data into Big Money.

Szczegółowa agenda oraz lista prelegentów jest dostępna na stronie internetowej konferencji.

Data:

5 listopada 2013

09:00 - 17:00

Miejsce:

Szkoła Wyższa Handlowa w Warszawie

Budynek C

Al. Niepodległości 128

02-554 Warszawa

Kontakt

seminarium@spl.sas.com

Partner merytoryczny konferencji: SAS Institute

Sponsorzy: ABE-IPS, Bank Gospodarstwa Krajowego, Sygma Bank

Patroni medialni: Computerworld, Harvard Business Review Polska, Manager

Konferencja "Advanced Analytics and Data Science" to wyjątkowe wydarzenie dla przedstawicieli świata nauki i biznesu, którego celem jest zaprezentowanie wymiernych wartości wynikających z zastosowania zaawansowanych rozwiązań analitycznych w biznesie oraz zainicjowanie dyskusji na temat wyzwań związanych z uruchamianiem nowych programów studiów i kształceniem specjalistów posiadających odpowiednie kompetencje analityczne, informatyczne i biznesowe (data scientist) dostosowane do zmieniających potrzeb współczesnej gospodarki.

Konferencja organizowana jest przez Szkołę Główną Handlową w Warszawie (Kolegium Analiz Ekonomicznych - Instytut Statystyki i Demografii - Zakład Analizy Historii Zdarzeń i Analizy Wielopoziomowych) pod honorowym patronatem JM Rektora – prof. dr hab. Tomasza Szapiro.

Wiele polskich uczelni, w tym Szkoła Główna Handlowa w Warszawie, przechodzi przez proces zmian i adaptacji programów kształcenia do aktualnych realiów rynku. Organizacje chcą wykorzystać możliwości, jakie kryją się za analizą i wizualizacją zalewających ich danych i informacji. Dlatego rośnie znaczenie data science zarówno jako specjalizacji i zawodu, jak i dyscypliny naukowej. Big Data zmienia oblicze biznesu, dlatego firmy potrzebują zaawansowanych technologii i specjalistycznych kompetencji, aby przekształcić dostępne dane w wiedzę zapewniającą im przewagę konkurencyjną.

Gościem specjalnym konferencji będzie Frank J. Ohlhorst – dziennikarz, autor, prezenter i blogger, ekspert w dziedzinie analityki biznesowej z dużym doświadczeniem w realizacji projektów IT dla biznesu. Autor książki Big Data Analytics: Turning Big Data into Big Money.

Szczegółowa agenda oraz lista prelegentów jest dostępna na stronie internetowej konferencji.

Data:

5 listopada 2013

09:00 - 17:00

Miejsce:

Szkoła Wyższa Handlowa w Warszawie

Budynek C

Al. Niepodległości 128

02-554 Warszawa

Kontakt

seminarium@spl.sas.com

Partner merytoryczny konferencji: SAS Institute

Sponsorzy: ABE-IPS, Bank Gospodarstwa Krajowego, Sygma Bank

Patroni medialni: Computerworld, Harvard Business Review Polska, Manager

niedziela, 29 września 2013

Oracle wprowadza aktualizacje platformy Oracle ERP Cloud

Aby pomóc firmom w uproszczeniu procesów finansowych i spełnić ich wymagania techniczne, Oracle wprowadza aktualizacje platformy chmurowej Oracle ERP Cloud. Rozszerzenia platformy pomogą firmom w zwiększeniu produktywności, obniżeniu kosztów i usprawnieniu kontroli biznesowej.

Praktyczne, dostosowane do ról konsole biznesowe, nowoczesne sposoby obsługi i wbudowane funkcje ułatwiające współpracę na różnych obszarach ułatwiają klientom efektywne zarządzanie nowoczesnymi organizacjami.

Oracle ERP Cloud to kompleksowe, zintegrowane rozwiązanie będące częścią platformy Oracle Cloud. Obejmuje następujące funkcjonalności: Oracle Financials Cloud, Oracle Procurement Cloud, Oracle Project Portfolio Management Cloud i Oracle Supply Chain Management Cloud.

Oto nowe funkcjonalności Oracle ERP Cloud:

Oracle Financials Cloud:

Wielowymiarowa platforma tworzenia raportów: Umożliwia tworzenie kompleksowych raportów na podstawie najnowszych informacji finansowych, wykorzystując dane pochodzące z jednego źródła.

Integracja arkuszy kalkulacyjnych i rozwiązań do przetwarzania obrazów: Obniża koszty przetwarzania danych i zmniejsza ilość błędów podczas wprowadzania transakcji.

Konsole biznesowe i obszary robocze oparte na rolach: Ułatwiają zarządzanie działaniami dzięki temu, że zadania, problemy i wyjątki przekazywane są bezpośrednio do scentralizowanego kokpitu.

Skalowalna i niezawodna platforma: Może przetwarzać ponad 200 milionów wpisów do dzienników na godzinę.

Oracle Procurement Cloud:

Automatyzacja: Pomaga w obniżeniu kosztów produktów i usług, uproszczeniu procesów „od źródła do rozliczenia" i zapewnieniu zgodności z przepisami.

Strategiczne wyszukiwanie źródeł i zawieranie umów: Ułatwia automatyzację i standaryzację negocjacji z dostawcami.

Samoobsługowe zaopatrzenie: Umożliwia mniej doświadczonym użytkownikom łatwy zakup produktów i usług od preferowanych dostawców po cenie zgodnej z umową.

Portal dla dostawców: Zapewnia centralny punkt współpracy z dostawcami, gdzie mogą oni sprawdzać status transakcji i podejmować w związku z tym odpowiednie działania.

Oracle Project Portfolio Management (PPM) Cloud:

Zarządzanie finansami: Umożliwia klientom osiągnięcie, a nawet przekroczenie celów dotyczących projektów dzięki najwyższej klasy funkcjom tworzenia budżetów, szacowania kosztów, przeprowadzania rozliczeń i zarządzania umowami.

Zarządzanie realizacją zadań: Przyspiesza pozyskiwanie pracowników i realizację projektów, zwiększa produktywność i ułatwia osiągnięcie dobrych wyników dzięki odpowiedniemu zarządzaniu zasobami projektowymi i zadaniami.

Sieci społecznościowe: Umożliwia współpracę w czasie rzeczywistym z wykorzystaniem wbudowanych narzędzi do komunikacji w sieciach społecznościowych.

Wgląd w wydajność: Ułatwia podejmowanie decyzji o działaniach niezbędnych do osiągnięcia sukcesu z uwzględnieniem głównych trendów biznesowych.

Oracle Supply Chain Management (SCM) Cloud:

Globalna kontrola zapasów: Umożliwia prewencyjne zarządzanie przepływem materiałów i pracą magazynów z wykorzystaniem kompleksowych funkcji zarządzania zapasami.

Elastyczne zarządzanie kosztami produkcji: Ułatwia kompleksowe zarządzanie kosztami produktów, od tworzenia raportów po podejmowanie decyzji.

Zarządzanie danymi głównymi produktów w przedsiębiorstwie: Obejmuje zarządzanie danymi głównymi produktu, kontrolę jakości w pętli zamkniętej, zarządzanie produktami i wprowadzanie rozszerzeń.

Sanmargar Team jest firmą Business Intelligence. Naszą strategią jest oferowanie eksperckich usług i rozwiązań do zarządzania danymi podstawowymi (MS - MetaStudio), deduplikacji i czyszczenia danych adresowych (DQS – DataQuality Studio) oraz rozwiązania do zarządzania jakością danych (DQMS - DataQualityManagement Studio). W naszych przedsięwzięciach, obok korporacyjnych rozwiązań o najwyższym standardzie (Oracle Hyperion, SAP BusinessObjects, Prophix), stosujemy także wydajne, w pełni funkcjonalne, rozwiązania oparte na otwartym kodzie źródłowym (Pentaho Business Analytics, SugarCRM, Redmine).

Od 2005 roku specjalizujemy się w dostarczaniu usług i rozwiązań w zakresie wspomagania zarządzania wykorzystując autorskie, oraz standardowe, narzędzia informatyczne. Podstawowych obszarem usług jest realizacja projektów dot. zarządzania danymi podstawowymi, zarządzania jakością danych oraz budowy wydajnych systemów wspomagających zarządzanie.

Praktyczne, dostosowane do ról konsole biznesowe, nowoczesne sposoby obsługi i wbudowane funkcje ułatwiające współpracę na różnych obszarach ułatwiają klientom efektywne zarządzanie nowoczesnymi organizacjami.

Oracle ERP Cloud to kompleksowe, zintegrowane rozwiązanie będące częścią platformy Oracle Cloud. Obejmuje następujące funkcjonalności: Oracle Financials Cloud, Oracle Procurement Cloud, Oracle Project Portfolio Management Cloud i Oracle Supply Chain Management Cloud.

Oto nowe funkcjonalności Oracle ERP Cloud:

Oracle Financials Cloud:

Wielowymiarowa platforma tworzenia raportów: Umożliwia tworzenie kompleksowych raportów na podstawie najnowszych informacji finansowych, wykorzystując dane pochodzące z jednego źródła.

Integracja arkuszy kalkulacyjnych i rozwiązań do przetwarzania obrazów: Obniża koszty przetwarzania danych i zmniejsza ilość błędów podczas wprowadzania transakcji.

Konsole biznesowe i obszary robocze oparte na rolach: Ułatwiają zarządzanie działaniami dzięki temu, że zadania, problemy i wyjątki przekazywane są bezpośrednio do scentralizowanego kokpitu.

Skalowalna i niezawodna platforma: Może przetwarzać ponad 200 milionów wpisów do dzienników na godzinę.

Oracle Procurement Cloud:

Automatyzacja: Pomaga w obniżeniu kosztów produktów i usług, uproszczeniu procesów „od źródła do rozliczenia" i zapewnieniu zgodności z przepisami.

Strategiczne wyszukiwanie źródeł i zawieranie umów: Ułatwia automatyzację i standaryzację negocjacji z dostawcami.

Samoobsługowe zaopatrzenie: Umożliwia mniej doświadczonym użytkownikom łatwy zakup produktów i usług od preferowanych dostawców po cenie zgodnej z umową.

Portal dla dostawców: Zapewnia centralny punkt współpracy z dostawcami, gdzie mogą oni sprawdzać status transakcji i podejmować w związku z tym odpowiednie działania.

Oracle Project Portfolio Management (PPM) Cloud:

Zarządzanie finansami: Umożliwia klientom osiągnięcie, a nawet przekroczenie celów dotyczących projektów dzięki najwyższej klasy funkcjom tworzenia budżetów, szacowania kosztów, przeprowadzania rozliczeń i zarządzania umowami.

Zarządzanie realizacją zadań: Przyspiesza pozyskiwanie pracowników i realizację projektów, zwiększa produktywność i ułatwia osiągnięcie dobrych wyników dzięki odpowiedniemu zarządzaniu zasobami projektowymi i zadaniami.

Sieci społecznościowe: Umożliwia współpracę w czasie rzeczywistym z wykorzystaniem wbudowanych narzędzi do komunikacji w sieciach społecznościowych.

Wgląd w wydajność: Ułatwia podejmowanie decyzji o działaniach niezbędnych do osiągnięcia sukcesu z uwzględnieniem głównych trendów biznesowych.

Oracle Supply Chain Management (SCM) Cloud:

Globalna kontrola zapasów: Umożliwia prewencyjne zarządzanie przepływem materiałów i pracą magazynów z wykorzystaniem kompleksowych funkcji zarządzania zapasami.

Elastyczne zarządzanie kosztami produkcji: Ułatwia kompleksowe zarządzanie kosztami produktów, od tworzenia raportów po podejmowanie decyzji.

Zarządzanie danymi głównymi produktów w przedsiębiorstwie: Obejmuje zarządzanie danymi głównymi produktu, kontrolę jakości w pętli zamkniętej, zarządzanie produktami i wprowadzanie rozszerzeń.

Sanmargar Team jest firmą Business Intelligence. Naszą strategią jest oferowanie eksperckich usług i rozwiązań do zarządzania danymi podstawowymi (MS - MetaStudio), deduplikacji i czyszczenia danych adresowych (DQS – DataQuality Studio) oraz rozwiązania do zarządzania jakością danych (DQMS - DataQualityManagement Studio). W naszych przedsięwzięciach, obok korporacyjnych rozwiązań o najwyższym standardzie (Oracle Hyperion, SAP BusinessObjects, Prophix), stosujemy także wydajne, w pełni funkcjonalne, rozwiązania oparte na otwartym kodzie źródłowym (Pentaho Business Analytics, SugarCRM, Redmine).

Od 2005 roku specjalizujemy się w dostarczaniu usług i rozwiązań w zakresie wspomagania zarządzania wykorzystując autorskie, oraz standardowe, narzędzia informatyczne. Podstawowych obszarem usług jest realizacja projektów dot. zarządzania danymi podstawowymi, zarządzania jakością danych oraz budowy wydajnych systemów wspomagających zarządzanie.

czwartek, 26 września 2013

Wzrost o 382 proc. w usługach związanych z tzw. chmurą obliczeniową (cloud computing)

Ponad 29 miliardów dolarów w 2017 roku mają wynieść zyski z mobilnych płatności w największych krajach rozwijających się. Spektakularne prognozy wzrostu dotyczą również dwóch innych narzędzi sektora TMT, mobilnej pomocy medycznej oraz chmury obliczeniowej - wynika z raportu pt. TMT Generation Next: ”Five pathways to TMT growth in emerging markets” Linklaters & Ovum.

Kraje rozwijające się stanowią największe źródło dochodów dla firm z sektora telekomunikacji, mediów i technologii (TMT) w obliczu globalnej stagnacji wzrostu przychodów w tym przemyśle. Nasycenie rynku i spadek rentowności są dalekie od dwucyfrowego wzrostu, do którego przedsiębiorstwa i ich inwestorzy przywykli. Najsilniejsi obecnie gracze TMT skupiają swoją uwagę na obietnicy wysokiego wzrostu, oferowanej przez gospodarki krajów rozwijających się tj.: Brazylii, Rosji, Indii, Chin, Indonezji, Republiki Południowej Afryki, Malezji, Meksyku, Nigerii oraz Kenii.

Płatności mobilne, czyli tzw. mobile money zawdzięczają swój szybki rozwój przede wszystkim ogromnej liczbie użytkowników telefonów komórkowych. Kancelaria Linklaters szacuje, że w 2017 roku 876 milionów użytkowników płatności mobilnych z rynków wschodzących stanowić będzie 86 proc. całkowitego, światowego rynku płatności mobilnych.

Przeszkody jakie mogą stanąć na drodze do osiągnięcia takiego wyniku przez kraje rozwijające się to: restrykcyjne regulacje prawne, skomplikowane systemy podatkowe, jakość oraz interoperacyjność usług.

- Dla instytucji finansowych i kartowych, wykorzystanie telefonów komórkowych stwarza możliwość dotarcia do rynków, na których do tej pory nie opłacało się skupiać. Znaczy to również, że gracze rynkowi, którzy zdecydowali się na inwestycje w krajach rozwijających się, muszą stawić czoła konkurencji, którą w normalnej sytuacji byliby w stanie zdominować - podkreślają eksperci Linklaters.

Mniej spektakularny, ale również wysoki wzrost - o 382 proc. - będziemy mogli zaobserwować w usługach związanych z tzw. chmurą obliczeniową (cloud computing). Stanie się to za sprawą tańszych, bardziej elastycznych i wyższej jakości usług internetowo-telekomunikacyjnych, jakie oferuje ta technologia. Przewidywane zyski na rynkach wschodzących związane z zastosowaniem chmury obliczeniowej do roku 2017 mogą sięgnąć przeszło 10 miliardów dolarów.

Trzecim wyróżniającym się trendem rynkowym, obserwowanym w krajach rozwijających się, są usługi mobilnej pomocy medycznej (mobile health), szczególnie ważne dla tych krajów ze względu na słaby dostęp do służby zdrowia i niskie dochody ludności. Podstawowe usługi mobile health to linia telefoniczna z informacją zdrowotną oraz przesyłanie drogą SMS informacji o zalecanym leczeniu. W 2012 roku dochody pochodzące z usług mobilnej pomocy medycznej, osiągnięte na rynkach wschodzących, wyniosły 3,15 miliardów dolarów. Autorzy raportu przewidują, że w 2017 roku wzrosną one do 8,79 miliardów dolarów.

----------------------------------------------------------------------------------------------------------

Sanmargar Team is a Poland based BI company. Provides solutions in consulting, deployment, training, and technical support related to wide aspect of Business Intelligence like Data Integration, Corporate / Departmental Reporting, Data Quality, Planning & Budgeting. Sanmargar Team is a provider of unique Master Data Management solution "MetaStudio". We use first-class commercial and open-source products to transform needs to business value because Your "business first".

Kraje rozwijające się stanowią największe źródło dochodów dla firm z sektora telekomunikacji, mediów i technologii (TMT) w obliczu globalnej stagnacji wzrostu przychodów w tym przemyśle. Nasycenie rynku i spadek rentowności są dalekie od dwucyfrowego wzrostu, do którego przedsiębiorstwa i ich inwestorzy przywykli. Najsilniejsi obecnie gracze TMT skupiają swoją uwagę na obietnicy wysokiego wzrostu, oferowanej przez gospodarki krajów rozwijających się tj.: Brazylii, Rosji, Indii, Chin, Indonezji, Republiki Południowej Afryki, Malezji, Meksyku, Nigerii oraz Kenii.

Płatności mobilne, czyli tzw. mobile money zawdzięczają swój szybki rozwój przede wszystkim ogromnej liczbie użytkowników telefonów komórkowych. Kancelaria Linklaters szacuje, że w 2017 roku 876 milionów użytkowników płatności mobilnych z rynków wschodzących stanowić będzie 86 proc. całkowitego, światowego rynku płatności mobilnych.

Przeszkody jakie mogą stanąć na drodze do osiągnięcia takiego wyniku przez kraje rozwijające się to: restrykcyjne regulacje prawne, skomplikowane systemy podatkowe, jakość oraz interoperacyjność usług.

- Dla instytucji finansowych i kartowych, wykorzystanie telefonów komórkowych stwarza możliwość dotarcia do rynków, na których do tej pory nie opłacało się skupiać. Znaczy to również, że gracze rynkowi, którzy zdecydowali się na inwestycje w krajach rozwijających się, muszą stawić czoła konkurencji, którą w normalnej sytuacji byliby w stanie zdominować - podkreślają eksperci Linklaters.

Mniej spektakularny, ale również wysoki wzrost - o 382 proc. - będziemy mogli zaobserwować w usługach związanych z tzw. chmurą obliczeniową (cloud computing). Stanie się to za sprawą tańszych, bardziej elastycznych i wyższej jakości usług internetowo-telekomunikacyjnych, jakie oferuje ta technologia. Przewidywane zyski na rynkach wschodzących związane z zastosowaniem chmury obliczeniowej do roku 2017 mogą sięgnąć przeszło 10 miliardów dolarów.

Trzecim wyróżniającym się trendem rynkowym, obserwowanym w krajach rozwijających się, są usługi mobilnej pomocy medycznej (mobile health), szczególnie ważne dla tych krajów ze względu na słaby dostęp do służby zdrowia i niskie dochody ludności. Podstawowe usługi mobile health to linia telefoniczna z informacją zdrowotną oraz przesyłanie drogą SMS informacji o zalecanym leczeniu. W 2012 roku dochody pochodzące z usług mobilnej pomocy medycznej, osiągnięte na rynkach wschodzących, wyniosły 3,15 miliardów dolarów. Autorzy raportu przewidują, że w 2017 roku wzrosną one do 8,79 miliardów dolarów.

----------------------------------------------------------------------------------------------------------

Sanmargar Team is a Poland based BI company. Provides solutions in consulting, deployment, training, and technical support related to wide aspect of Business Intelligence like Data Integration, Corporate / Departmental Reporting, Data Quality, Planning & Budgeting. Sanmargar Team is a provider of unique Master Data Management solution "MetaStudio". We use first-class commercial and open-source products to transform needs to business value because Your "business first".

środa, 25 września 2013

In-memory: Oracle Database w pamięci

Na konferencję Oracle Open World w tym roku przyjechało 60,000 osób. Jednocześnie odbywa się kilkadziesiąc równoległych sesji tematycznych i otwartych jest 500 stoisk, co może dezorientować.

W niedzielę wieczór wydarzenie otwarł keynote Larry Ellisona, szefa Oracle. Tegoroczne ogłoszenia wydały się z pozoru nader skromne. Larry obiecał mianowicie wprowadzenie opcji In-Memory do bazy danych Oracle w jej ostatniej inkarnacji (wersja 12c). Oznacza to, że tabele będą mogły być opcjonalnie przechowane w pamięci, przy 100x zwiększeniu prędkości dostępu I/O. Towarzyszy temu pomysł ciekawy dla technologów: dane będą dostępne jednocześnie w formacie tradycyjnym, w organizacji wierszowej, jak i w postaci kolumnowej optymalnej dla zastosowań analitycznych. Możemy wybrać sposób dostępu.

W niedzielę wieczór wydarzenie otwarł keynote Larry Ellisona, szefa Oracle. Tegoroczne ogłoszenia wydały się z pozoru nader skromne. Larry obiecał mianowicie wprowadzenie opcji In-Memory do bazy danych Oracle w jej ostatniej inkarnacji (wersja 12c). Oznacza to, że tabele będą mogły być opcjonalnie przechowane w pamięci, przy 100x zwiększeniu prędkości dostępu I/O. Towarzyszy temu pomysł ciekawy dla technologów: dane będą dostępne jednocześnie w formacie tradycyjnym, w organizacji wierszowej, jak i w postaci kolumnowej optymalnej dla zastosowań analitycznych. Możemy wybrać sposób dostępu.

Czy to ogłoszenie godne uwagi rynku? Wydawałoby się że nie. Nie został ogłoszony żaden dramatyczny zwrot strategii firmy.

Waga tego komunikatu znacząco rośnie jeśli zrozumiemy jego rynkowy kontekst. Po pierwsze, Oracle jest pod wzmożonym ostrzałem szeregu mniejszych konkurentów próbujących odkroić kawałek rynku bazodanowego dla siebie. W sillicon Valley wyrosło szereg technologii NoSQL, na czele z Cassandra, MongoDB i Hadoop – których hasłem jest łatwa skalowalność do kilkuset węzłów. Oracle skaluje się tak dobrze. W Ameryce (w przeciwieństwie do Polski) wiele firm przechowuje w bazach Oracle również dane niekrytyczne związane z ruchem na stronie www, i te w pierwszej kolejności padają łatwym łupem tanich dostawców NoSQL. Oracle, wrzucając bazę do pamięci, daje sygnał rynkowi: wkrótce operacje w Oracle Database przyśpieszą kilkusetkrotnie. Zamiast planować projekt migracji do innych technologii i kupować kilkaset serwerów, lepiej wstrzymaj się - zainwestuj w jeden serwer i dobrą pamięć RAM. Zgodnie z zasadą „działa – nie rusz”, klienci będą więc teraz mniej chętnie migrować do Mongo. Haczyk? Owszem, bo alternatywą jest inna migracja – do 12c. Jednak jest to migracja o wiele prostsza. Z doświadczenia Gridwise: jeśli upgrade do nowej wersji bazy danych to kilka tygodni pracy, to migracja do innej technologii przetwarzania zabiera rok.

poniedziałek, 16 września 2013

Nowa wersja Pentaho 5.0 już dostępna

Odpowiedź na potrzebę analizy i dostępu do dużych ilości nowych typów danych.

12 września 2013r miała miejsce premiera nowej wersji platformy analitycznej – Pentaho 5.0. Wersja Pentaho 5.0 jest odpowiedzią na rosnące oczekiwania użytkowników kompleksowych analiz, oczekujących dostępu do dużych ilości i nowych typów danych. Potrzeby takie niesie ze sobą koncepcja gromadzenia i przetwarzania danych w Big Data. Jednocześnie użytkownicy wymagają funkcji ułatwiających przygotowywanie raportów, korzystanie z nich i udostępnianie bez względu na wielkość zbioru danych i ich komplikacje. Pentaho 5.0, został zaprojektowany zgodnie z tymi oczekiwaniami tak, by zapewnić jednolitą platformę dostępu i spójną analizę wszystkich danych, w każdym środowisku, w pełnym spektrum potrzeb analitycznych.

W zaktualizowanej wersji producenci wprowadzili wiele nowych funkcjonalności znacznie poprawiając ergonomię i estetykę interfejsów. Nowoczesny pulpit upraszcza analitykę danych sprawiając, że jest dostępna dla wszystkich użytkowników dając im przewagę konkurencyjną.

Mobilna wersja rozwiązania odpowiada najnowszym trendom dając możliwość błyskawicznego podglądu do analiz ważnych obszarów. Interaktywne, dotykowe panele pozwalają na zadawanie dowolnych pytań

i obserwację wyników w postaci popularnych wykresów kolumnowych, liniowych, punktowych, bąbelkowych, zlokalizowanych na mapach i wielu innych. Funkcjonalność taka idealnie sprawdzi się gdy zajdzie konieczność przeprowadzenia atrakcyjnej prezentacji danych na spotkaniu. Pulpity znacznie zyskały na funkcjonalności dzięki bogactwu możliwości jakie daje technologia mobilna. Projektowanie i edytowanie wielowymiarowych analiz, tworzenie wizualizacji i sprawozdań nie wymaga pomocy działu IT.

Nasze doświadczenia pokazują, że biznes oczekuje od analitycznych i rozwiązań raportowych większej elastyczności pozwalającej na samodzielne konfigurowanie zapytań bez udziału informatyków, możliwości intuicyjnego kształtowania raportu i rodzaju wykresu w zależności od potrzeb oraz mobilności.

Zapisywanie i przechowywanie danych w chmurze pozwala członkom zarządów, managerom i analitykom pracować w dowolnym miejscu i czasie bez wsparcia działu IT. Przygotowanie spotkania nie wymaga dodatkowej pracy związanej z obróbką i konfiguracją raportów wynikowych. Prezentacja danych uzyskanych drogą analizy może odbywać się na żywo. Naturalne przeglądanie wyników, powiększanie przez dotyk, formatowanie za pomocą funkcji ‘drag and drop’, personalizacja dla każdego użytkownika poprzez ‘tagowanie’ dokumentów to tylko wybrane, spośród nowych funkcji.

W nowej wersji Pentaho Business Analytics, doceniony wcześniej dzięki otwartej architekturze i atrakcyjnej polityce cenowej, staje się jeszcze bardziej atrakcyjną platformą analityczno-raportową i poważną konkurencją dla rozwiązań korporacyjnych dostawców.

Sanmargar Team jako czołowy dostawca Platformy Pentaho Business Analytics zaprasza do nieodpłatnego zapoznania się z możliwościami tego rozwiązania oraz nową polityką licencyjną producenta.

Więcej informacji na temat nowej wersji:

http://www.pentaho.com/resource/whats-new-pentaho-business-analytics-50

http://www.pentaho.com/5.0

O Sanmargar Team:

Sanmargar Team jest jednym z czołowych dostawców rozwiązań business intelligence. Oferuje usługi z zakresu integracji systemów informatycznych, projektowania i wdrażania hurtowni danych, systemów analityki biznesowej i raportowania oraz rozwiązań dedykowanych do zarządzania jakością danych.

W szczególności oferta Sanmargar Team dotyczy dostawy rozwiązań i usług wspomagających zarządzanie jakością, czyszczeniem oraz przetwarzaniem danych. Sanmargar Team jest producentem unikatowych, na polskim rynku, rozwiązań do zarządzania danymi podstawowymi (MetaStudio), rozwiązania do czyszczenia danych (DQS – Data Quality Studio) oraz rozwiązania do zarządzania jakością danych (DQMS – Data Quality Management Studio).

Chętnie odpowiemy na wszelkie pytania.

Ireneusz Chmielak

Pełnomocnik Zarządu

Sanmargar Team sp. z o.o. 03-973 Warszawa, ul. Brukselska 17a

www.sanmargar.pl

tel. (22) 870-10-54; e-mail:listy@sanmargar.pl

12 września 2013r miała miejsce premiera nowej wersji platformy analitycznej – Pentaho 5.0. Wersja Pentaho 5.0 jest odpowiedzią na rosnące oczekiwania użytkowników kompleksowych analiz, oczekujących dostępu do dużych ilości i nowych typów danych. Potrzeby takie niesie ze sobą koncepcja gromadzenia i przetwarzania danych w Big Data. Jednocześnie użytkownicy wymagają funkcji ułatwiających przygotowywanie raportów, korzystanie z nich i udostępnianie bez względu na wielkość zbioru danych i ich komplikacje. Pentaho 5.0, został zaprojektowany zgodnie z tymi oczekiwaniami tak, by zapewnić jednolitą platformę dostępu i spójną analizę wszystkich danych, w każdym środowisku, w pełnym spektrum potrzeb analitycznych.

W zaktualizowanej wersji producenci wprowadzili wiele nowych funkcjonalności znacznie poprawiając ergonomię i estetykę interfejsów. Nowoczesny pulpit upraszcza analitykę danych sprawiając, że jest dostępna dla wszystkich użytkowników dając im przewagę konkurencyjną.

Mobilna wersja rozwiązania odpowiada najnowszym trendom dając możliwość błyskawicznego podglądu do analiz ważnych obszarów. Interaktywne, dotykowe panele pozwalają na zadawanie dowolnych pytań

i obserwację wyników w postaci popularnych wykresów kolumnowych, liniowych, punktowych, bąbelkowych, zlokalizowanych na mapach i wielu innych. Funkcjonalność taka idealnie sprawdzi się gdy zajdzie konieczność przeprowadzenia atrakcyjnej prezentacji danych na spotkaniu. Pulpity znacznie zyskały na funkcjonalności dzięki bogactwu możliwości jakie daje technologia mobilna. Projektowanie i edytowanie wielowymiarowych analiz, tworzenie wizualizacji i sprawozdań nie wymaga pomocy działu IT.

Nasze doświadczenia pokazują, że biznes oczekuje od analitycznych i rozwiązań raportowych większej elastyczności pozwalającej na samodzielne konfigurowanie zapytań bez udziału informatyków, możliwości intuicyjnego kształtowania raportu i rodzaju wykresu w zależności od potrzeb oraz mobilności.

Zapisywanie i przechowywanie danych w chmurze pozwala członkom zarządów, managerom i analitykom pracować w dowolnym miejscu i czasie bez wsparcia działu IT. Przygotowanie spotkania nie wymaga dodatkowej pracy związanej z obróbką i konfiguracją raportów wynikowych. Prezentacja danych uzyskanych drogą analizy może odbywać się na żywo. Naturalne przeglądanie wyników, powiększanie przez dotyk, formatowanie za pomocą funkcji ‘drag and drop’, personalizacja dla każdego użytkownika poprzez ‘tagowanie’ dokumentów to tylko wybrane, spośród nowych funkcji.

W nowej wersji Pentaho Business Analytics, doceniony wcześniej dzięki otwartej architekturze i atrakcyjnej polityce cenowej, staje się jeszcze bardziej atrakcyjną platformą analityczno-raportową i poważną konkurencją dla rozwiązań korporacyjnych dostawców.

Sanmargar Team jako czołowy dostawca Platformy Pentaho Business Analytics zaprasza do nieodpłatnego zapoznania się z możliwościami tego rozwiązania oraz nową polityką licencyjną producenta.

Więcej informacji na temat nowej wersji:

http://www.pentaho.com/resource/whats-new-pentaho-business-analytics-50

http://www.pentaho.com/5.0

O Sanmargar Team:

Sanmargar Team jest jednym z czołowych dostawców rozwiązań business intelligence. Oferuje usługi z zakresu integracji systemów informatycznych, projektowania i wdrażania hurtowni danych, systemów analityki biznesowej i raportowania oraz rozwiązań dedykowanych do zarządzania jakością danych.

W szczególności oferta Sanmargar Team dotyczy dostawy rozwiązań i usług wspomagających zarządzanie jakością, czyszczeniem oraz przetwarzaniem danych. Sanmargar Team jest producentem unikatowych, na polskim rynku, rozwiązań do zarządzania danymi podstawowymi (MetaStudio), rozwiązania do czyszczenia danych (DQS – Data Quality Studio) oraz rozwiązania do zarządzania jakością danych (DQMS – Data Quality Management Studio).

Chętnie odpowiemy na wszelkie pytania.

Ireneusz Chmielak

Pełnomocnik Zarządu

Sanmargar Team sp. z o.o. 03-973 Warszawa, ul. Brukselska 17a

www.sanmargar.pl

tel. (22) 870-10-54; e-mail:listy@sanmargar.pl

sobota, 14 września 2013

Niewiele firm na świecie może obecnie skorzystać z Big Data

IBM opublikował fragment raportu, z którego dowiadujemy się, że tak naprawdę niewiele firm na świecie może obecnie skorzystać z Big Data.

Raport jest częścią publikowanych dziesięciu lat C-suite Studies. Samo badanie składa się z rozmów z ponad 4000 przedstawicieli kadry zarządzającej z całego świata. Przedstawiciele IBM Institute for Business Value rozmawiali z CEO’s, CFO’s, CIO’s, CMO’s, CSCO’s i CHRO’s z całego świata na temat wyzwań stojących przed nimi i ich firmami i na temat nadchodzących możliwości rozwoju. Pełna wersja raportu (w tym raport lokalny) powinny zostać opublikowane w okolicach października tego roku.

Obecnie przedstawiono jedynie garść interesujących faktów, które udało się wyciągnąć z badań. Dowiadujemy się, że w roku 2013, 34% ankietowanych firm powiedziało, że posiada dogłębną wiedzę na temat swoich klientów. W roku 2017 ma ją mieć 78% firm.

Obecnie przedstawiono jedynie garść interesujących faktów, które udało się wyciągnąć z badań. Dowiadujemy się, że w roku 2013, 34% ankietowanych firm powiedziało, że posiada dogłębną wiedzę na temat swoich klientów. W roku 2017 ma ją mieć 78% firm.

69% badanej kadry zarządzającej powiedziało ponadto, że jednym z najważniejszych zadań stojących przed nimi, jest stworzenie „spójnego doświadczenia” na wszystkich punktach styku biznes-klient. Co ciekawe, jedynie 40% ankietowanych łączy dane wewnętrzne i zewnętrze w celu pogłębienia uzyskanej wiedzy. Jeszcze mniej – 18% - przyznało, że korzysta z Big Data do identyfikowania nowych, potrzebnych produktów i usług.

IBM twierdzi również, że jedynie co piąta badana firma posiada obecnie możliwość korzystania z Big Data.

IBM twierdzi również, że jedynie co piąta badana firma posiada obecnie możliwość korzystania z Big Data.

Z infografiki towarzyszącej publikacji dowiadujemy się również, że:

- 77% dyrektorów finansowych twierdzi, że wspiera rozwój nowych produktów i usług

- 71% dyrektorów IT uważa, że zwykła komunikacja przesuwa się w kierunku kolaboracji, współpracy w mediach społecznościowych

- 64% dyrektorów marketingu chce traktować swych klientów jako osobne jednostki

- 63% dyrektorów zarządzających chce większego partnerstwa, współpracy, by osiągnąć większą wartość biznesową

- 55% dyrektorów personalnych przewiduje, że otwartość organizacji wzrośnie

- 19% dyrektorów ds. dostaw przewiduje nadchodzące zmniejszenie bazy swoich partnerów

-------------------------------------------------------------------------------------------

Sanmargar Team jest jednym z czołowych dostawców rozwiązań

business intelligence na Polskim Rynku. Oferuje usługi z zakresu integracji

systemów informatycznych, projektowania i wdrażania hurtowni danych oraz

rozwiązań dedykowanych do zarządzania jakością danych.

czwartek, 12 września 2013

IBM zwiększa wsparcie dla Big Data

Firma przedstawi nowe produkty i funkcjonalności mające pomóc firmom w zarządzaniu Big Data..

Amerykańska firma chce wprowadzić ład i porządek na tym Dzikim Zachodzie. Zamierza to zrobić poprzez zwiększenie możliwości już oferowanego oprogramowania oraz tworzenie zupełnie nowych rozwiązań. W trakcie odbywającej się w tym tygodniu konferencji Building Confidence in Big Data, IBM zaprezentował część swoich pomysłów.

Do oprogramowania InfoSphere dodane zostaną zupełnie nowe funkcje. Jedna z nich to Data Click. Funkcja ta pozwala w prosty sposób wyciągać dane ze zbiorów, w tym takich, które działają w oparciu o NoSQL oraz Hadoopa. Kolejna nowa funkcja – Big Insights – pozwala w prosty sposób tworzyć katalog metadanych, który ma być prostszy do przetwarzania dla dużych firm.

Do poszczególnych wersji InfoSphere można także wprowadzić funkcję Big Master. Umożliwia ona gromadzenie wszystkich dostępnych informacji na temat dowolnego klienta. Dane zbierane są zarówno z zasobów firmowych, jak i publicznych źródeł, takich jak wpisy użytkownika na Twitterze czy historia przeprowadzanych przez niego transakcji, zakupów.

InfoSphere otrzyma również specjalny pulpit pokazujący w jakim stanie utrzymywane są źródła big data. Dzięki temu prostsze ma być dostosowanie ich do firmowych przepisów dotyczących bezpieczeństwa oraz spójności danych. Firma poinformowała również, że do powszechnej dystrybucji trafiło PureData System dla Hadoop, z którego od kwietnia tego roku korzystało już wąskie grono odbiorców.

IBM zapowiedział również powstanie usługi konsultingowej Big Data Stampede. Została ona utworzona w celu pomagania potencjalnym klientom z opracowaniem strategii Big Data.

Polecamy pełną wersję artykuły >

------------------------------------------------------------------------------------------------------------

Sanmargar Team jest jednym z czołowych dostawców rozwiązań business intelligence na Polskim Rynku. Oferuje usługi z zakresu integracji systemów informatycznych, projektowania i wdrażania hurtowni danych oraz rozwiązań dedykowanych do zarządzania jakością danych.

W szczególności oferta Sanmargar Team dotyczy wdrożeń rozwiązań business intelligence służących wspomaganiu zarządzania i rachunkowości zarządczej. Projekty business intelligence Sanmargar realizuje w oparciu o rozwiązania partnerskie takie jak: SAP BusinessObjects, Oracle EPM, Oracle Hyperion, Microsoft, Pentaho, Actuate, TargIT, Prophix.

Oferuje usługi z zakresu doradztwa w procesach finansowych i organizacyjnych oraz technologii informa-tycznych obejmujące analizy wymagań, studia wykonalności, projektowania i wdrożeń systemów wspierających zarządzanie. Założyciele, konsultanci i współpracownicy Sanmargar Team zdobywali doświadczenia

w wielu projektach analizy i wdrożeń rozwiązań IT w sektorach: finansowym, mediowym, ubezpieczenio-wym, logistycznym, energetycznym, wydobywczym oraz telekomunikacyjnym.

Sanmargar jest również producentem rozwiązań uzupełniających dostępne produkty BI m.in. rozwiązania do zarządzania danymi podstawowymi (MetaStudio), rozwiązania do kontroli jakości i czyszczenia danych (DQS – Data Quality Studio), rozwiązania monitorujące jakość danych (DQMS – Data Quality Management Studio) oraz rozwiązania do wprowadzania korekt na danych Hurtowni Danych (DataFix Studio).

Amerykańska firma chce wprowadzić ład i porządek na tym Dzikim Zachodzie. Zamierza to zrobić poprzez zwiększenie możliwości już oferowanego oprogramowania oraz tworzenie zupełnie nowych rozwiązań. W trakcie odbywającej się w tym tygodniu konferencji Building Confidence in Big Data, IBM zaprezentował część swoich pomysłów.

Do oprogramowania InfoSphere dodane zostaną zupełnie nowe funkcje. Jedna z nich to Data Click. Funkcja ta pozwala w prosty sposób wyciągać dane ze zbiorów, w tym takich, które działają w oparciu o NoSQL oraz Hadoopa. Kolejna nowa funkcja – Big Insights – pozwala w prosty sposób tworzyć katalog metadanych, który ma być prostszy do przetwarzania dla dużych firm.

Do poszczególnych wersji InfoSphere można także wprowadzić funkcję Big Master. Umożliwia ona gromadzenie wszystkich dostępnych informacji na temat dowolnego klienta. Dane zbierane są zarówno z zasobów firmowych, jak i publicznych źródeł, takich jak wpisy użytkownika na Twitterze czy historia przeprowadzanych przez niego transakcji, zakupów.

InfoSphere otrzyma również specjalny pulpit pokazujący w jakim stanie utrzymywane są źródła big data. Dzięki temu prostsze ma być dostosowanie ich do firmowych przepisów dotyczących bezpieczeństwa oraz spójności danych. Firma poinformowała również, że do powszechnej dystrybucji trafiło PureData System dla Hadoop, z którego od kwietnia tego roku korzystało już wąskie grono odbiorców.

IBM zapowiedział również powstanie usługi konsultingowej Big Data Stampede. Została ona utworzona w celu pomagania potencjalnym klientom z opracowaniem strategii Big Data.

Polecamy pełną wersję artykuły >

------------------------------------------------------------------------------------------------------------

Sanmargar Team jest jednym z czołowych dostawców rozwiązań business intelligence na Polskim Rynku. Oferuje usługi z zakresu integracji systemów informatycznych, projektowania i wdrażania hurtowni danych oraz rozwiązań dedykowanych do zarządzania jakością danych.

W szczególności oferta Sanmargar Team dotyczy wdrożeń rozwiązań business intelligence służących wspomaganiu zarządzania i rachunkowości zarządczej. Projekty business intelligence Sanmargar realizuje w oparciu o rozwiązania partnerskie takie jak: SAP BusinessObjects, Oracle EPM, Oracle Hyperion, Microsoft, Pentaho, Actuate, TargIT, Prophix.

Oferuje usługi z zakresu doradztwa w procesach finansowych i organizacyjnych oraz technologii informa-tycznych obejmujące analizy wymagań, studia wykonalności, projektowania i wdrożeń systemów wspierających zarządzanie. Założyciele, konsultanci i współpracownicy Sanmargar Team zdobywali doświadczenia

w wielu projektach analizy i wdrożeń rozwiązań IT w sektorach: finansowym, mediowym, ubezpieczenio-wym, logistycznym, energetycznym, wydobywczym oraz telekomunikacyjnym.

Sanmargar jest również producentem rozwiązań uzupełniających dostępne produkty BI m.in. rozwiązania do zarządzania danymi podstawowymi (MetaStudio), rozwiązania do kontroli jakości i czyszczenia danych (DQS – Data Quality Studio), rozwiązania monitorujące jakość danych (DQMS – Data Quality Management Studio) oraz rozwiązania do wprowadzania korekt na danych Hurtowni Danych (DataFix Studio).

czwartek, 23 maja 2013

Nowe podejście do Business Intelligence

Wielkie efekty małej rewolucji w zarządzaniu jakością danych - według Sanmargar Team na Konferencji Polish Business Analytics Summit (21-22 maja 2013r).

„Kredytujemy klientów, którzy nam nie płacą”.”Nasi partnerzy nie zamawiają takich ilości produktów własnych, do jakich się zobowiązali i mamy kłopot aby to udowodnić”.”Chcielibyśmy optymalizować koszty produkcji, ale nie umiemy dobrze policzyć kosztów wytworzenia. Problemy stwarza nam oszacowanie ceny wewnętrznych usług”.”Nasi klienci tracą do nas zaufanie z powodu błędnych danych w systemie CRM. Zdarza się, że handlowiec oferuje produkt w cenie promocyjnej klientowi, który już go kupił ponosząc pełny koszt.”…

To tylko wybrane, z problemów biznesowych, z jakimi klienci co dzień trafiają do Sanmargar Team. Są to najczęściej średnie bądź duże przedsiębiorstwa, grupy kapitałowe działające w konkretnych branżach, albo firmy posiadające wiele rozproszonych oddziałów. Zazwyczaj zgłaszający się posiadają nie jeden, a wiele różnych systemów informatycznych wspierających zarządzanie. Na czym więc polega problem? Jest nim niska jakość raportów biznesowych spowodowana dezintegracją danych i błędami w nich, to rodzi brak zaufania do rozwiązań BI. Systemy, których zadaniem jest usprawnianie konkretnych procesów biznesowych spowalniają je bądź utrudniają, bo muszą korzystać z niekompletnych danych.

Problemy te nie znikną, ale będą się nasilać wraz ze wzrostem zainteresowania Big Data i koniecznością przetwarzania danych w chmurze. Biznes na całym świecie ma wielkie nadzieje związane z analizą coraz większych ilości informacji w czasie rzeczywistym, bo czy chcielibyśmy lecieć samolotem, którego pilot zdecydował się na start dysponując tylko danymi przybliżonymi, bądź przewidywaniami? Osoby zarządzające firmami mają podobne wymagania. Chcą podejmować ważne decyzje na podstawie rzeczywistych i aktualnych informacji. Przeszkodą dla systemów analitycznych, raportujących, ERP i CRM jest niska jakość danych, błędy, różnorodność formatów, niska kaloryczność informacji gromadzonych przez rozwiązania statystyczne. Stąd wynika większość problemów biznesowych organizacji, które inwestowały w te systemy, ale nadal nie są zadowolone z efektów ich pracy.

Wychodząc im naprzeciw Sanmargar Team w czasie Polish Business Analytics Summit przedstawił uniwersalne rozwiązania, których celem jest czyszczenie i integracja danych, a także zarządzanie słownikami danych podstawowych już na wczesnym etapie Business Intelligence, gdy dane trafiają do hurtowni i są przetwarzanie na potrzeby konkretnych rozwiązań, czy analitycznych, czy też wspierających wybrane procesy biznesowe od zarządzania finansami, przez sprzedaż, obsługę klienta, aż po obrót należnościami. Przebieg tych procesów jest również zapisywany w sposób uporządkowany, dzięki zarządzaniu słownikami danych podstawowych.

Wraz ze wzrostem jakości danych rośnie zaufanie do wyników analiz, posiadane przez firmę systemy zaczynają działać wydajniej, a bazujący na ich pracy ludzie popełniają mniej błędów. Kierownicy w firmie produkcyjnej są w stanie szybo udzielić odpowiedzi na pytanie: ile kosztują poszczególne etapy wytworzenia konkretnego produktu i z czym te koszty są związane. Sprzedawcy nie oferują klientom usług, które Ci posiadają, albo jak wynika z zapisanej historii nie potrzebują.

Takie podejście, zrodzone z konkretnej praktyki jest absolutnie innowacyjne. Rozszerza przyjęty sposób rozumienia Business Intelligence, które dla specjalistów Sanmargar Team zaczyna się już na wczesnym etapie, gdy dane są gromadzone i przetwarzane w hurtowniach danych na potrzeby wszelkich rozwiązań i podmiotów, które będą z nich korzystać. Koncentracja na tym wycinku pracy systemów business intelligence już w 2011 roku wprowadziła Sanmargar Team na piąte miejsce wśród potentatów BI w Polsce ( Computerworld: Raport TOP 2011 ), gdzie spółka została wymieniona po takich graczach jak: SAP Polska, SAS Institute, Oracle Polska i Stanusch Technologies.

Analizując cztery konkretne przypadki biznesowe w czasie Polish Business Analytics Summit (21-22 maja 2013) Krzysztof Korytko, zarządzający Pionem Usług w Sanmargar Team przedstawi to innowacyjne podejście do procesów zarządzania informacją, przekonując obecnych na konferencji i w panelach warsztatowych specjalistów do szerszego spojrzenia na zagadnienia business inteligece.

Zainteresowanych takim podejściem, którzy z różnych przyczyn nie znajdą się wśród gości konferencji Sanmargar Team zaprasza na nieodpłatne warsztaty szkoleniowe przez cały rok.

Sanmargar Team

Spółka istnieje od 2005r. W ciągu 6 lat istnienia osiągnęła status jednego z kluczowych dostawców Business Intelligence na rynku polskim. Sanmargar Team i SAS Institute są głównymi partnerami Polish Business Analytics Summit (21-22 maja 2013).

Sanmargar team obsługuje duże i średnie firmy w zakresie wdrożenia i integracji systemów wspierających procesy zarządzania i wytwarzania oraz tworzenia i zarządzania hurtowniami danych. Spółkę wyróżniają własne narzędzia do czyszczenia i integracji danych oraz do zarządzania słownikami danych podstawowych:

• MetaStudio MDM. Platforma wspomagająca zarządzanie danymi podstawowymi (MDM), algorytmami i słownikami reguł.

• DataQualityStudio (DQS). Produkt realizujący czyszczenie/deduplikacje danych.

piątek, 19 kwietnia 2013

Big Data w służbie ochrony zdrowia

Narzędziami, które umożliwiają analizowanie dużych baz danych (Big Data) interesują się w ostatnich kilkunastu miesiącach niemal wszystkie sektory, zarówno w skali lokalnej jak i globalnej. Jak na razie ta nowatorska technologia wykorzystywana jest przede wszystkim przez instytucje finansowe, firmy informatyczne i telekomunikacyjne.

Tymczasem, zdaniem ekspertów firmy doradczej Deloitte, jej naturalnym adresatem powinny stać się także firmy farmaceutyczne i ochrony zdrowia. Analizy oparte na ogromnej ilości stale zmieniających się danych pozwolą im bowiem nie tylko prowadzić działalność naukowo-badawczą (B+R) czy odkrywać nowe leki, ale także identyfikować i zapobiegać różnym nieprawidłowościom w działalności operacyjnej, jak choćby niedozwolonym operacjom finansowym oraz praktykom korupcyjnym.

W sektorze farmaceutycznym i ochrony zdrowia dane stanowią jeden z kluczowych zasobów przedsiębiorstwa. Zawierają one wyniki prowadzonych badań, efekty stosowania poszczególnych leków, informacje o ich skutkach ubocznych, a także pełen zapis operacji gospodarczych odzwierciedlających prowadzoną działalność. Umiejętność pozyskiwania danych, ich analizowania, wzbogacania i wykorzystania jest jednym z najważniejszych elementów mogących stanowić o wzroście lub utracie wartości firmy.

Raport Deloitte „Tech Trends 2013”, który dotyczy aktualnych trendów w wykorzystaniu technologii w biznesie wskazuje m.in., że duże zbiory danych mogą zawierać niedostrzegalne na pierwszy rzut oka zestawy informacji, których wykorzystanie może prowadzić do formułowania przełomowych spostrzeżeń. Warunkiem sukcesu jest umiejętność zidentyfikowania określonych wzorców ukrytych w gąszczu danych, a także dokonania ich właściwej analizy i interpretacji. Jest to szczególnie istotna informacja właśnie dla firm farmaceutycznych i ochrony zdrowia. (...)

Należy jednak zaznaczyć, że pozyskiwanie, przechowywanie oraz analiza danych muszą być prowadzone w zgodzie z obowiązującymi przepisami prawa, najlepszymi praktykami w zakresie bezpieczeństwa danych oraz etyką.

Big Data jest istotna również z czysto ekonomicznego punktu widzenia - w branży farmaceutycznej ma zastosowanie także typowo biznesowe. Po latach wzrostu gospodarczego przedsiębiorstwa z sektora farmaceutycznego i ochrony zdrowia stanęły w obliczu kryzysu. Wygasająca ochrona patentowa, wzrost konkurencji na rynku leków generycznych, długotrwałe spowolnienie gospodarcze oraz rosnąca presja cenowa powodują, że firmy z branży zmuszone są zwiększyć wysiłki w celu dostosowania się do nowej rzeczywistości. Skutkuje to redukcją zatrudnienia, mniejszymi nakładami na badania i rozwój oraz obniżką cen leków. Tymczasem zastosowanie Big Data pozwala obniżać koszty i przeciwdziałać nadużyciom. Dzięki analizie danych można szybko i skutecznie identyfikować nieuprawnione lub budzące wątpliwości operacje finansowe, a tym samym przeciwdziałać na przykład korupcji. Przedsiębiorstwa mogą z powodzeniem i sukcesem wykorzystać Big Data do zarządzania ryzykiem nadużyć, na przykład w zakresie analizy operacji księgowych, kartotek dostawców i pracowników lub zbiorów płatności. „Rosnąca liczba postępowań toczących się w związku z podejrzeniem popełnienia nadużyć oraz naruszenia przepisów antykorupcyjnych wskazuje, że jest to tematyka, która podlega szczególnej uwadze odpowiednich urzędów. Umiejętne wykorzystanie analizy danych umożliwia uniknięcie wysokich i dotkliwych kar nakładanych przez regulatorów oraz zachowanie reputacji, co ma zasadnicze znaczenie w branży służącej ochronie i poprawie ludzkiego życia i zdrowia” – mówi dr Bartłomiej Iwanowicz.

Należy jednak pamiętać, że odpowiednie oprogramowanie nie wystarczy. Kluczem do sukcesu jest przede wszystkim człowiek. Komputery są niezastąpione w identyfikacji wzorców ukrytych w zbiorach danych, ale osiągane w ten sposób rezultaty wymagają krytycznej oceny i selekcji. Dlatego też pozyskanie pracowników o odpowiednich kompetencjach, posiadających wiedzę i doświadczenie zarówno w obszarze IT, jak i biznesu stanowi wyzwanie dla firm.

(...)

Deloitte Polska

..................................................................................................................................................................

Sanmargar Team oferuje usługi z zakresu doradztwa w procesach związanych z gromadzeniem i przetwarzaniem dużych zbiorów danych oraz technologii informatycznych obejmujące analizy wymagań, studia wykonalności, projektowania i wdrożeń systemów wspierających zarządzanie (‘Business Intelligence’).

Sanmargar Team oferuje własne rozwiązania do zarządzania metadanymi, gromadzenia, czyszczenia, standaryzowania i analizowania danych uszeregowanych w formie słowników.

Naszą strategią jest oferowanie, obok korporacyjnych rozwiązań o najwyższym standardzie (Oracle Hyperion, SAP BusinessObjects), także wydajnych, w pełni funkcjonalnych, rozwiązań opartych na otwartym kodzie źródłowym (Pentaho Business Analytics) oraz własnych rozwiązań do zarządzania danymi podstawowymi (MetaStudio), kontroli jakości, deduplikacji i czyszczenia danych (DQS – DataQualityStudio).

Etykiety:

analiza,

Big Data,

Deloitte Polska,

medycyna,

metadane,

modele analityczne,

pharma,

przetwarzanie danych,

raportowanie,

SanMargar Team,

służba zdrowia

wtorek, 16 kwietnia 2013

Kto rządzi w świecie Big Data?

Cyfrowe dane są coraz częściej porównywane do ropy naftowej. Czy w przyszłości przyniosą równie wielkie profity? Odpowiedzi na to pytanie szukali analitycy portalu Wikibon.

Dane rosną w oszałamiającym tempie. Jeszcze w 2005 w cyfrowym wszechświecie krążyło 130 eksabajtów danych, pięć lat później było już 1227 eksabajtów. IDC przewiduje, że na koniec 2020 roku wartość ta przekroczy 40 tys. eksabajtów